入门

安装

docker run \

-e RABBITMQ_DEFAULT_USER=cwc \

-e RABBITMQ_DEFAULT_PASS=123321 \

-v mq-plugins:/plugins \

--name mq \

--hostname mq \

-p 15672:15672 \

-p 5672:5672 \

--network hmall \

-d \

rabbitmq:3.8-management可以看到在安装命令中有两个映射的端口:

- 15672:RabbitMQ提供的管理控制台的端口

- 5672:RabbitMQ的消息发送处理接口

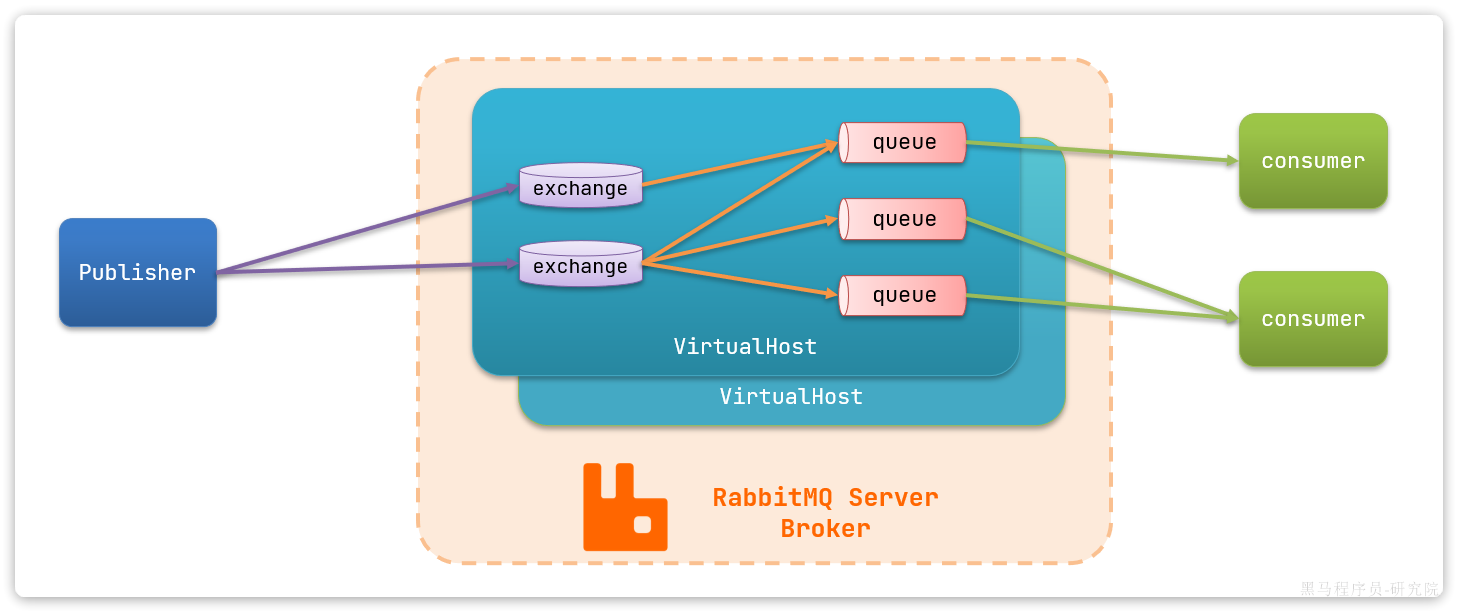

基本架构

其中包含几个概念:

publisher:生产者,也就是发送消息的一方consumer:消费者,也就是消费消息的一方queue:队列,存储消息。生产者投递的消息会暂存在消息队列中,等待消费者处理exchange:交换机,负责消息路由。生产者发送的消息由交换机决定投递到哪个队列。virtual host:虚拟主机,起到数据隔离的作用。每个虚拟主机相互独立,有各自的exchange、queue

SpringAMQP

AMQP:Advanced Message Queuing Protocol,是用于在应用程序之间传递业务消息的开放标准。该协议与语言和平台无关,更符合微服务中独立性的要求。

Spring AMQP:是基于AMQP协议定义的一套API规范,提供了模板来发送和接收消息。包含两部分,其中spring-amqp是基础抽象,spring-rabbit是底层的默认实现。

快速入门

配置

<!--AMQP依赖,包含RabbitMQ-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

</dependency>spring:

rabbitmq:

host: 192.168.150.101 # 你的虚拟机IP

port: 5672 # 端口

virtual-host: /hmall # 虚拟主机

username: hmall # 用户名

password: 123 # 密码消息发送

@SpringBootTest

public class SpringAmqpTest {

@Autowired

private RabbitTemplate rabbitTemplate;

@Test

public void testSimpleQueue() {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, spring amqp!";

// 发送消息

rabbitTemplate.convertAndSend(queueName, message);

}

}消息接收

@Component

public class SpringRabbitListener {

// 利用RabbitListener来声明要监听的队列信息

// 将来一旦监听的队列中有了消息,就会推送给当前服务,调用当前方法,处理消息。

// 可以看到方法体中接收的就是消息体的内容

@RabbitListener(queues = "simple.queue")

public void listenSimpleQueueMessage(String msg) throws InterruptedException {

System.out.println("spring 消费者接收到消息:【" + msg + "】");

}

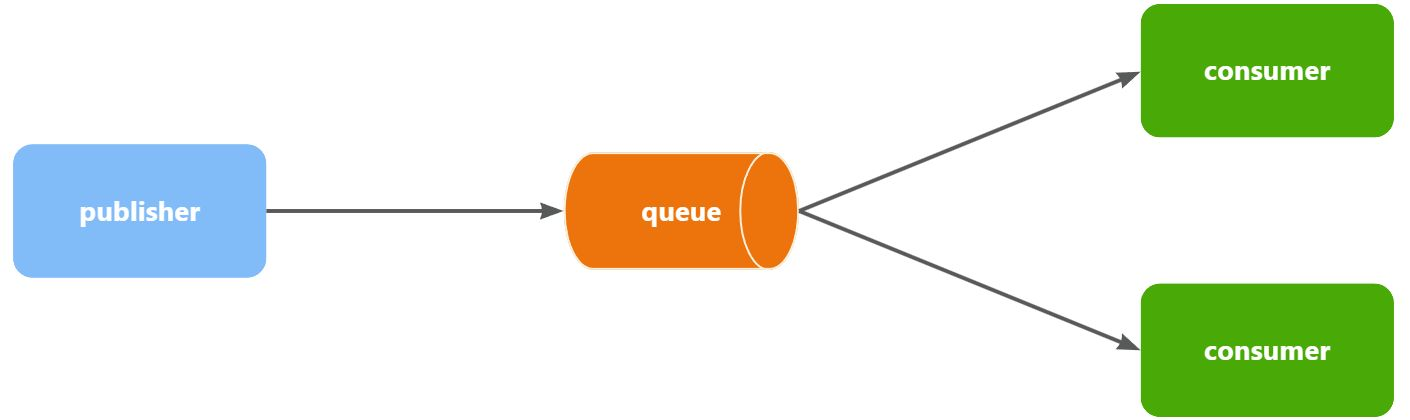

}WorkQueues模型

Work queues,任务模型。简单来说就是让多个消费者绑定到一个队列,共同消费队列中的消息。

消息发送

@Test

public void testWorkQueue() throws InterruptedException {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, message_";

for (int i = 0; i < 50; i++) {

// 发送消息,每20毫秒发送一次,相当于每秒发送50条消息

rabbitTemplate.convertAndSend(queueName, message + i);

Thread.sleep(20);

}

}消息接收

@RabbitListener(queues = "work.queue")

public void listenWorkQueue1(String msg) throws InterruptedException {

System.out.println("消费者1接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(20);

}

@RabbitListener(queues = "work.queue")

public void listenWorkQueue2(String msg) throws InterruptedException {

System.err.println("消费者2........接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(200);

}注意到这两消费者,都设置了Thead.sleep,模拟任务耗时:

- 消费者1 sleep了20毫秒,相当于每秒钟处理50个消息

- 消费者2 sleep了200毫秒,相当于每秒处理5个消息

测试

最终测试消费者1和消费者2竟然每人都消费了25条消息:

- 消费者1很快完成了自己的25条消息

- 消费者2却在缓慢的处理自己的25条消息。

消息是平均分配给每个消费者,并没有考虑到消费者的处理能力。

能者多劳

spring:

rabbitmq:

listener:

simple:

prefetch: 1 # 每次只能获取一条消息,处理完成才能获取下一个消息交换机类型

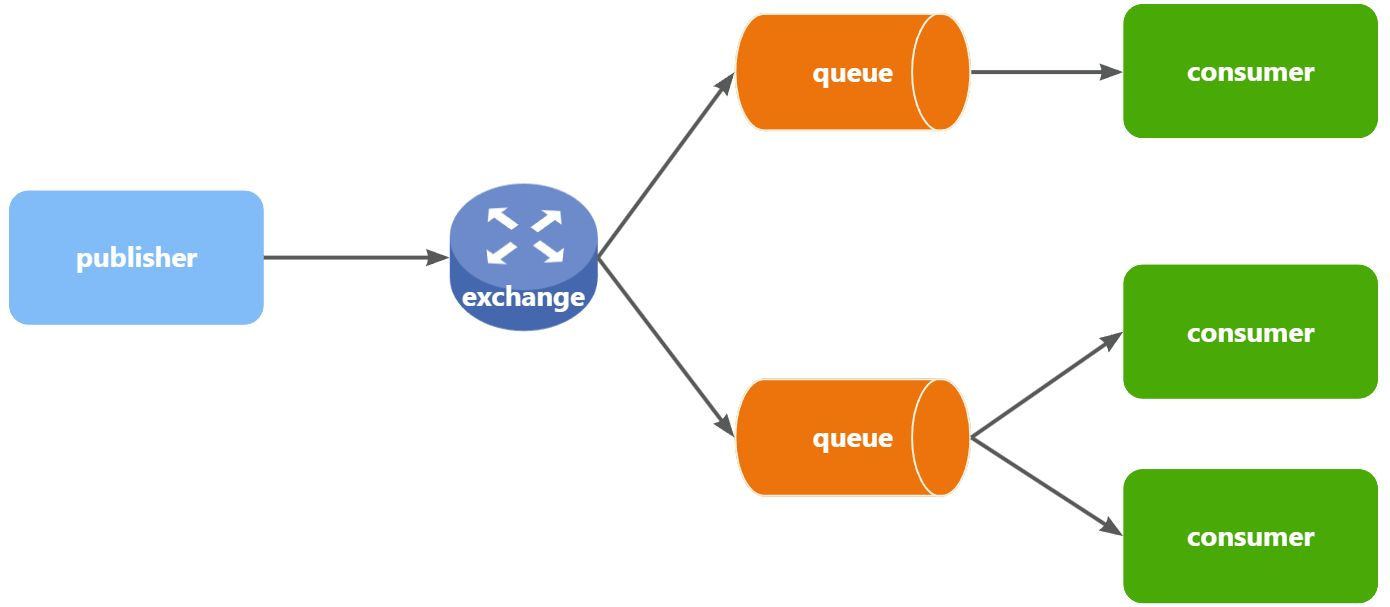

可以看到,在订阅模型中,多了一个exchange角色,而且过程略有变化:

- Publisher:生产者,不再发送消息到队列中,而是发给交换机

- Exchange:交换机,一方面,接收生产者发送的消息。另一方面,知道如何处理消息,例如递交给某个特别队列、递交给所有队列、或是将消息丢弃。到底如何操作,取决于Exchange的类型。

- Queue:消息队列也与以前一样,接收消息、缓存消息。不过队列一定要与交换机绑定。

- Consumer:消费者,与以前一样,订阅队列,没有变化

Exchange(交换机)只负责转发消息,不具备存储消息的能力,因此如果没有任何队列与Exchange绑定,或者没有符合路由规则的队列,那么消息会丢失!

交换机的类型有四种:

- Fanout:广播,将消息交给所有绑定到交换机的队列。我们最早在控制台使用的正是Fanout交换机

- Direct:订阅,基于RoutingKey(路由key)发送给订阅了消息的队列

- Topic:通配符订阅,与Direct类似,只不过RoutingKey可以使用通配符

- Headers:头匹配,基于MQ的消息头匹配,用的较少。

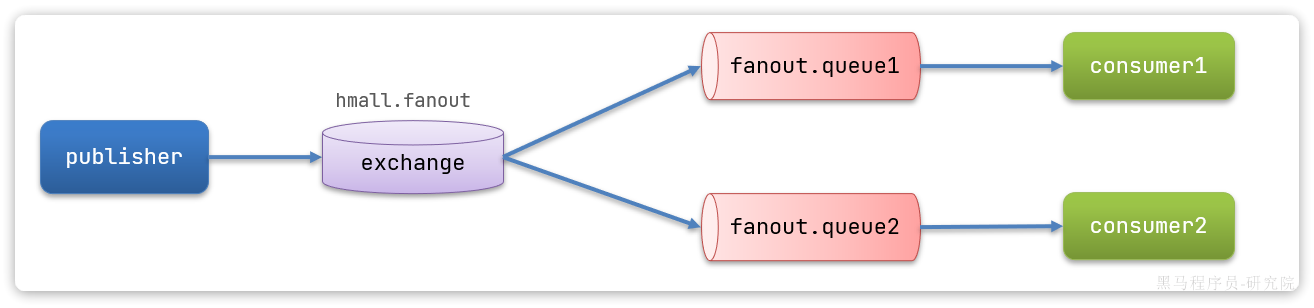

Fanout交换机

消息发送

@Test

public void testFanoutExchange() {

// 交换机名称

String exchangeName = "hmall.fanout";

// 消息

String message = "hello, everyone!";

rabbitTemplate.convertAndSend(exchangeName, "", message);

}消息接收

@RabbitListener(queues = "fanout.queue1")

public void listenFanoutQueue1(String msg) {

System.out.println("消费者1接收到Fanout消息:【" + msg + "】");

}

@RabbitListener(queues = "fanout.queue2")

public void listenFanoutQueue2(String msg) {

System.out.println("消费者2接收到Fanout消息:【" + msg + "】");

}Direct交换机

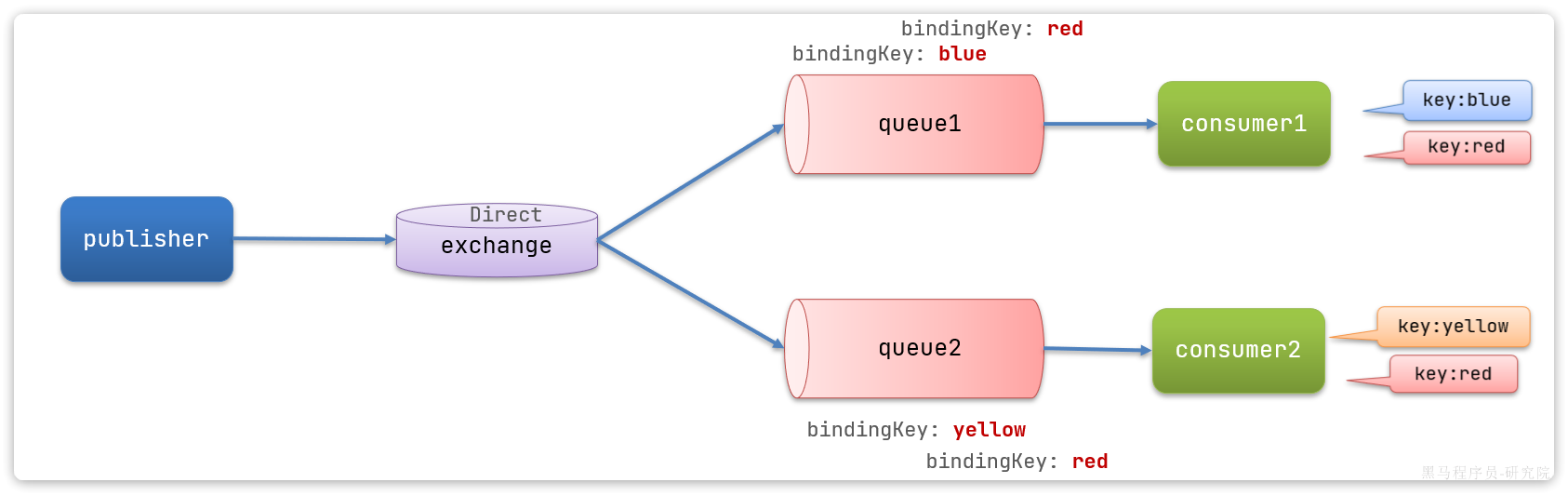

在Direct模型下:

- 队列与交换机的绑定,不能是任意绑定了,而是要指定一个

RoutingKey(路由key) - 消息的发送方在 向 Exchange发送消息时,也必须指定消息的

RoutingKey。 - Exchange不再把消息交给每一个绑定的队列,而是根据消息的

Routing Key进行判断,只有队列的Routingkey与消息的Routing key完全一致,才会接收到消息

消息发送

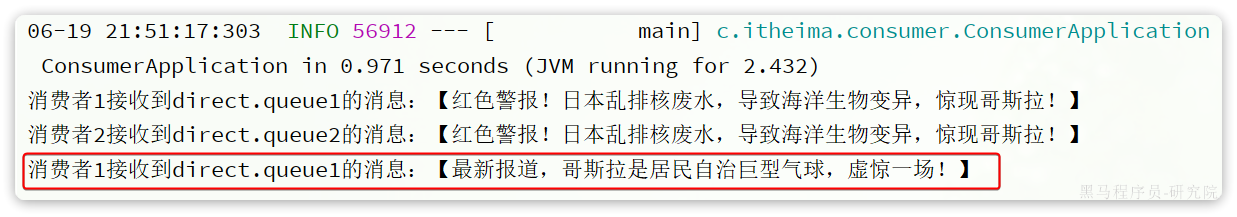

@Test

public void testSendDirectExchange() {

// 交换机名称

String exchangeName = "hmall.direct";

// 消息

String message_red = "红色警报!日本乱排核废水,导致海洋生物变异,惊现哥斯拉!";

String message_blue = "最新报道,哥斯拉是居民自治巨型气球,虚惊一场!";

// 发送消息

rabbitTemplate.convertAndSend(exchangeName, "red", message_red);

rabbitTemplate.convertAndSend(exchangeName, "blue", message_blue);

}消息接收

@RabbitListener(queues = "direct.queue1")

public void listenDirectQueue1(String msg) {

System.out.println("消费者1接收到direct.queue1的消息:【" + msg + "】");

}

@RabbitListener(queues = "direct.queue2")

public void listenDirectQueue2(String msg) {

System.out.println("消费者2接收到direct.queue2的消息:【" + msg + "】");

}

- Fanout交换机将消息路由给每一个与之绑定的队列

- Direct交换机根据RoutingKey判断路由给哪个队列

- 如果多个队列具有相同的RoutingKey,则与Fanout功能类似

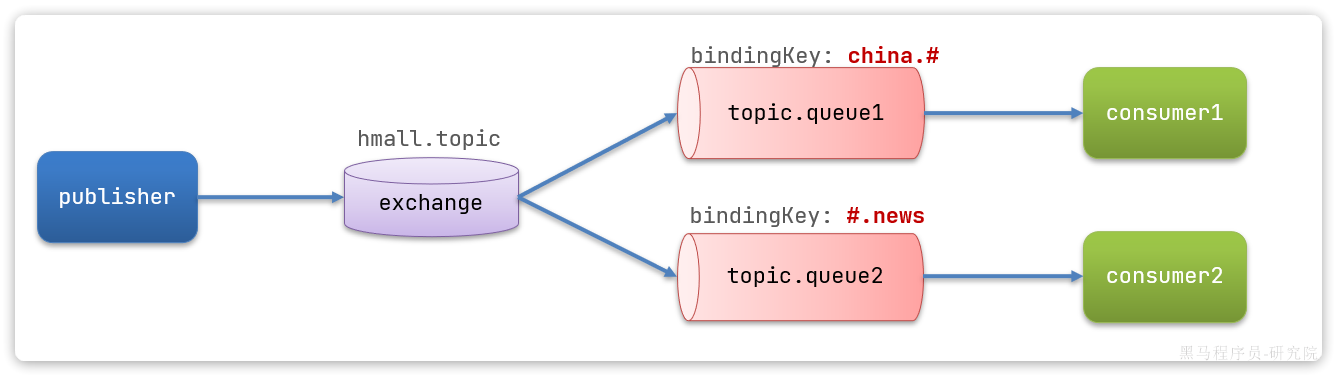

Topic交换机

Topic类型的Exchange与Direct相比,都是可以根据RoutingKey把消息路由到不同的队列。 只不过Topic类型Exchange可以让队列在绑定BindingKey 的时候使用通配符!

BindingKey 一般都是有一个或多个单词组成,多个单词之间以.分割,例如: item.insert

通配符规则:

#:匹配一个或多个词*:匹配不多不少恰好1个词

举例:

item.#:能够匹配item.spu.insert或者item.spuitem.*:只能匹配item.spu

假如此时publisher发送的消息使用的RoutingKey共有四种:

china.news代表有中国的新闻消息;china.weather代表中国的天气消息;japan.news则代表日本新闻japan.weather代表日本的天气消息;

解释:

topic.queue1:绑定的是china.#,凡是以china.开头的routing key都会被匹配到,包括:china.newschina.weather

topic.queue2:绑定的是#.news,凡是以.news结尾的routing key都会被匹配。包括:china.newsjapan.news

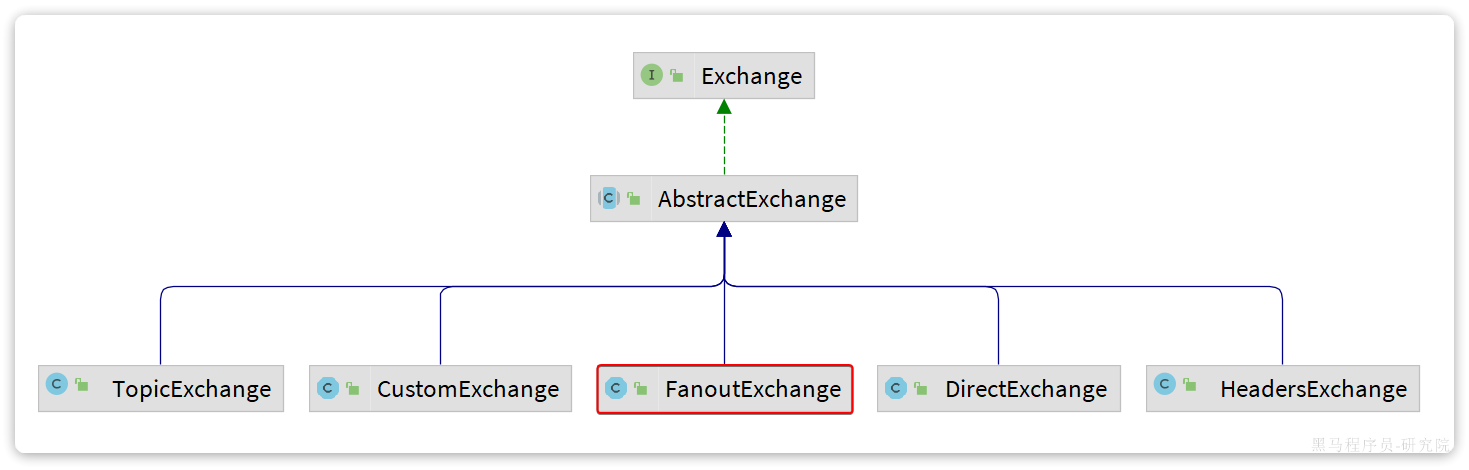

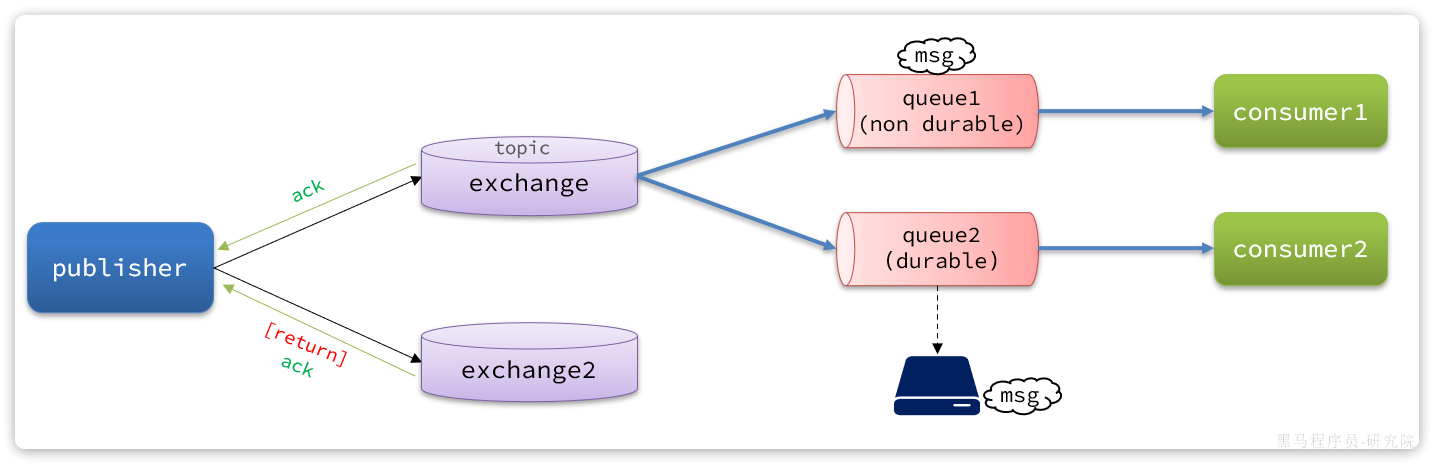

声明队列和交换机

基本API

- Queue:用于声明队列,可以用工厂类QueueBuilder构建

- Exchange:用于声明交换机,可以用工厂类ExchangeBuilder构建

- Binding:用于声明队列和交换机的绑定关系,可以用工厂类BindingBuilder构建

SpringAMQP提供了一个Exchange接口,来表示所有不同类型的交换机:

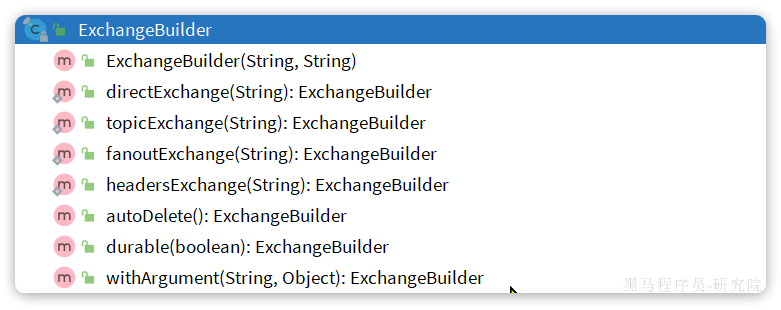

ExchangeBuilder

而在绑定队列和交换机时,则需要使用BindingBuilder来创建Binding对象:

fanout实例

@Configuration

public class FanoutConfig {

/**

* 声明交换机

* @return Fanout类型交换机

*/

@Bean

public FanoutExchange fanoutExchange(){

return new FanoutExchange("hmall.fanout");

}

/**

* 第1个队列

*/

@Bean

public Queue fanoutQueue1(){

return new Queue("fanout.queue1");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue1(Queue fanoutQueue1, FanoutExchange fanoutExchange){

return BindingBuilder.bind(fanoutQueue1).to(fanoutExchange);

}

/**

* 第2个队列

*/

@Bean

public Queue fanoutQueue2(){

return new Queue("fanout.queue2");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue2(){

return BindingBuilder.bind(fanoutQueue2()).to(fanoutExchange());

}

}direct示例

direct模式由于要绑定多个KEY,会非常麻烦,每一个Key都要编写一个binding,因此使用注解模式

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue1"),

exchange = @Exchange(name = "hmall.direct", type = ExchangeTypes.DIRECT),

key = {"red", "blue"}

))

public void listenDirectQueue1(String msg){

System.out.println("消费者1接收到direct.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue2"),

exchange = @Exchange(name = "hmall.direct", type = ExchangeTypes.DIRECT),

key = {"red", "yellow"}

))

public void listenDirectQueue2(String msg){

System.out.println("消费者2接收到direct.queue2的消息:【" + msg + "】");

}Topic示例

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue1"),

exchange = @Exchange(name = "hmall.topic", type = ExchangeTypes.TOPIC),

key = "china.#"

))

public void listenTopicQueue1(String msg){

System.out.println("消费者1接收到topic.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue2"),

exchange = @Exchange(name = "hmall.topic", type = ExchangeTypes.TOPIC),

key = "#.news"

))

public void listenTopicQueue2(String msg){

System.out.println("消费者2接收到topic.queue2的消息:【" + msg + "】");

}消息转换器

在数据传输时,它会把你发送的消息序列化为字节发送给MQ,接收消息的时候,还会把字节反序列化为Java对象。 只不过,默认情况下Spring采用的序列化方式是JDK序列化。众所周知,JDK序列化存在下列问题:

- 数据体积过大

- 有安全漏洞

- 可读性差

配置JSON转换器

显然,JDK序列化方式并不合适。我们希望消息体的体积更小、可读性更高,因此可以使用JSON方式来做序列化和反序列化。

在publisher和consumer两个服务中都引入依赖:

<dependency>

<groupId>com.fasterxml.jackson.dataformat</groupId>

<artifactId>jackson-dataformat-xml</artifactId>

<version>2.9.10</version>

</dependency>注意,如果项目中引入了spring-boot-starter-web依赖,则无需再次引入Jackson依赖。

配置消息转换器,在publisher和consumer两个服务的启动类中添加一个Bean即可:

@Bean

public MessageConverter messageConverter(){

// 1.定义消息转换器

Jackson2JsonMessageConverter jackson2JsonMessageConverter = new Jackson2JsonMessageConverter();

// 2.配置自动创建消息id,用于识别不同消息,也可以在业务中基于ID判断是否是重复消息

jackson2JsonMessageConverter.setCreateMessageIds(true);

return jackson2JsonMessageConverter;

}消息转换器中添加的messageId可以便于我们将来做幂等性判断。

发送者的可靠性

生产者重试机制

第一种情况,就是生产者发送消息时,出现了网络故障,导致与MQ的连接中断。

为了解决这个问题,SpringAMQP提供的消息发送时的重试机制。即:当RabbitTemplate与MQ连接超时后,多次重试。

修改publisher模块的application.yml文件,添加下面的内容:

spring:

rabbitmq:

connection-timeout: 1s # 设置MQ的连接超时时间

template:

retry:

enabled: true # 开启超时重试机制

initial-interval: 1000ms # 失败后的初始等待时间

multiplier: 1 # 失败后下次的等待时长倍数,下次等待时长 = initial-interval * multiplier

max-attempts: 3 # 最大重试次数注意:

- 当网络不稳定的时候,利用重试机制可以有效提高消息发送的成功率。不过SpringAMQP提供的重试机制是阻塞式的重试,也就是说多次重试等待的过程中,当前线程是被阻塞的。

- 如果对于业务性能有要求,建议禁用重试机制。如果一定要使用,请合理配置等待时长和重试次数,当然也可以考虑使用异步线程来执行发送消息的代码。

生产者确认机制

一般情况下,只要生产者与MQ之间的网路连接顺畅,基本不会出现发送消息丢失的情况,因此大多数情况下我们无需考虑这种问题。 不过,在少数情况下,也会出现消息发送到MQ之后丢失的现象,比如:

- MQ内部处理消息的进程发生了异常

- 生产者发送消息到达MQ后未找到

Exchange - 生产者发送消息到达MQ的

Exchange后,未找到合适的Queue,因此无法路由

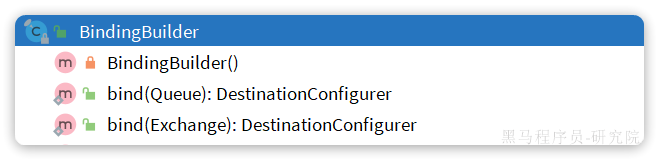

针对上述情况,RabbitMQ提供了生产者消息确认机制,包括Publisher Confirm和Publisher Return两种。在开启确认机制的情况下,当生产者发送消息给MQ后,MQ会根据消息处理的情况返回不同的回执。 具体如图所示:

总结如下:

- 当消息投递到MQ,但是路由失败时,通过Publisher Return返回异常信息,同时返回ack的确认信息,代表投递成功

- 临时消息投递到了MQ,并且入队成功,返回ACK,告知投递成功

- 持久消息投递到了MQ,并且入队完成持久化,返回ACK ,告知投递成功

- 其它情况都会返回NACK,告知投递失败

其中ack和nack属于Publisher Confirm机制,ack是投递成功;nack是投递失败。而return则属于Publisher Return机制。 默认两种机制都是关闭状态,需要通过配置文件来开启。

开启生产者确认

spring:

rabbitmq:

publisher-confirm-type: correlated # 开启publisher confirm机制,并设置confirm类型

publisher-returns: true # 开启publisher return机制这里publisher-confirm-type有三种模式可选:

none:关闭confirm机制simple:同步阻塞等待MQ的回执correlated:MQ异步回调返回回执

定义ReturnCallback

每个RabbitTemplate只能配置一个ReturnCallback,因此我们可以在配置类中统一设置。我们在publisher模块定义一个配置类:

@Slf4j

@AllArgsConstructor

@Configuration

public class MqConfig {

private final RabbitTemplate rabbitTemplate;

@PostConstruct

public void init(){

rabbitTemplate.setReturnsCallback(new RabbitTemplate.ReturnsCallback() {

@Override

public void returnedMessage(ReturnedMessage returned) {

log.error("触发return callback,");

log.debug("exchange: {}", returned.getExchange());

log.debug("routingKey: {}", returned.getRoutingKey());

log.debug("message: {}", returned.getMessage());

log.debug("replyCode: {}", returned.getReplyCode());

log.debug("replyText: {}", returned.getReplyText());

}

});

}

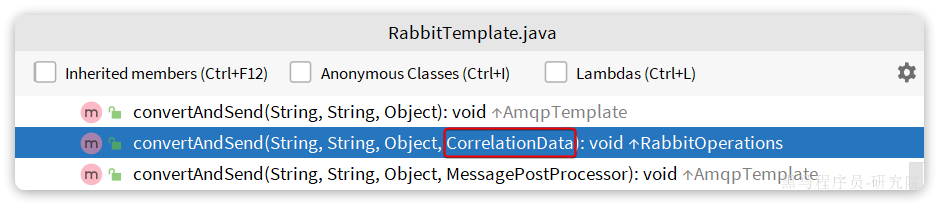

}定义ConfirmCallback

由于每个消息发送时的处理逻辑不一定相同,因此ConfirmCallback需要在每次发消息时定义。具体来说,是在调用RabbitTemplate中的convertAndSend方法时,多传递一个参数:

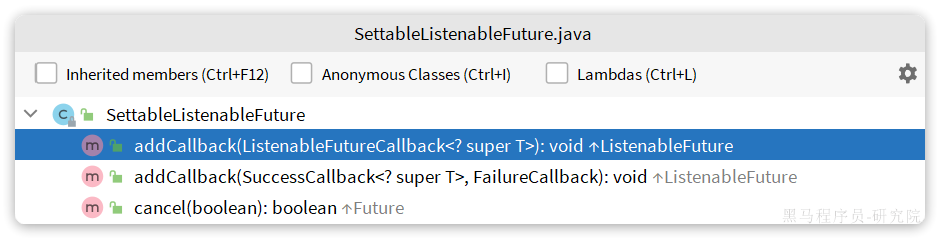

这里的CorrelationData中包含两个核心的东西:

id:消息的唯一标示,MQ对不同的消息的回执以此做判断,避免混淆SettableListenableFuture:回执结果的Future对象

将来MQ的回执就会通过这个Future来返回,我们可以提前给CorrelationData中的Future添加回调函数来处理消息回执:

@Test

void testPublisherConfirm() {

// 1.创建CorrelationData

CorrelationData cd = new CorrelationData();

// 2.给Future添加ConfirmCallback

cd.getFuture().addCallback(new ListenableFutureCallback<CorrelationData.Confirm>() {

@Override

public void onFailure(Throwable ex) {

// 2.1.Future发生异常时的处理逻辑,基本不会触发

log.error("send message fail", ex);

}

@Override

public void onSuccess(CorrelationData.Confirm result) {

// 2.2.Future接收到回执的处理逻辑,参数中的result就是回执内容

if(result.isAck()){ // result.isAck(),boolean类型,true代表ack回执,false 代表 nack回执

log.debug("发送消息成功,收到 ack!");

}else{ // result.getReason(),String类型,返回nack时的异常描述

log.error("发送消息失败,收到 nack, reason : {}", result.getReason());

}

}

});

// 3.发送消息

rabbitTemplate.convertAndSend("hmall.direct", "q", "hello", cd);

}开启生产者确认比较消耗MQ性能,一般不建议开启。而且大家思考一下触发确认的几种情况:

- 路由失败:一般是因为RoutingKey错误导致,往往是编程导致

- 交换机名称错误:同样是编程错误导致

- MQ内部故障:这种需要处理,但概率往往较低。因此只有对消息可靠性要求非常高的业务才需要开启,而且仅仅需要开启ConfirmCallback处理nack就可以了。

MQ的可靠性

数据持久化(Durable)

为了提升性能,默认情况下MQ的数据都是在内存存储的临时数据,重启后就会消失。为了保证数据的可靠性,必须配置数据持久化,包括:

- 交换机持久化

- 队列持久化

- 消息持久化

LazyQueue

在默认情况下,RabbitMQ会将接收到的信息保存在内存中以降低消息收发的延迟。但在某些特殊情况下,这会导致消息积压,比如:

- 消费者宕机或出现网络故障

- 消息发送量激增,超过了消费者处理速度

- 消费者处理业务发生阻塞

一旦出现消息堆积问题,RabbitMQ的内存占用就会越来越高,直到触发内存预警上限。此时RabbitMQ会将内存消息刷到磁盘上,这个行为成为PageOut. PageOut会耗费一段时间,并且会阻塞队列进程。因此在这个过程中RabbitMQ不会再处理新的消息,生产者的所有请求都会被阻塞。

为了解决这个问题,从RabbitMQ的3.6.0版本开始,就增加了Lazy Queues的模式,也就是惰性队列。惰性队列的特征如下:

- 接收到消息后直接存入磁盘而非内存

- 消费者要消费消息时才会从磁盘中读取并加载到内存(也就是懒加载)

- 支持数百万条的消息存储

而在3.12版本之后,LazyQueue已经成为所有队列的默认格式。因此官方推荐升级MQ为3.12版本或者所有队列都设置为LazyQueue模式。

配置Lazy模式

@Bean

public Queue lazyQueue(){

return QueueBuilder

.durable("lazy.queue")

.lazy() // 开启Lazy模式

.build();

}@RabbitListener(queuesToDeclare = @Queue(

name = "lazy.queue",

durable = "true",

arguments = @Argument(name = "x-queue-mode", value = "lazy")

))

public void listenLazyQueue(String msg){

log.info("接收到 lazy.queue的消息:{}", msg);

}消费者的可靠性

为了确认消费者是否成功处理消息,RabbitMQ提供了消费者确认机制(Consumer Acknowledgement)。即:当消费者处理消息结束后,应该向RabbitMQ发送一个回执,告知RabbitMQ自己消息处理状态。回执有三种可选值:

- ack:成功处理消息,RabbitMQ从队列中删除该消息

- nack:消息处理失败,RabbitMQ需要再次投递消息

- reject:消息处理失败并拒绝该消息,RabbitMQ从队列中删除该消息

配置

由于消息回执的处理代码比较统一,因此SpringAMQP帮我们实现了消息确认。并允许我们通过配置文件设置ACK处理方式,有三种模式:

none:不处理。即消息投递给消费者后立刻ack,消息会立刻从MQ删除。非常不安全,不建议使用manual:手动模式。需要自己在业务代码中调用api,发送ack或reject,存在业务入侵,但更灵活auto:自动模式。SpringAMQP利用AOP对我们的消息处理逻辑做了环绕增强,当业务正常执行时则自动返回ack. 当业务出现异常时,根据异常判断返回不同结果:- 如果是业务异常,会自动返回

nack; - 如果是消息处理或校验异常,自动返回

reject;

- 如果是业务异常,会自动返回

spring:

rabbitmq:

listener:

simple:

acknowledge-mode: auto失败重试机制

当消费者出现异常后,消息会不断requeue(重入队)到队列,再重新发送给消费者。如果消费者再次执行依然出错,消息会再次requeue到队列,再次投递,直到消息处理成功为止。

spring:

rabbitmq:

listener:

simple:

retry:

enabled: true # 开启消费者失败重试

initial-interval: 1000ms # 初识的失败等待时长为1秒

multiplier: 1 # 失败的等待时长倍数,下次等待时长 = multiplier * last-interval

max-attempts: 3 # 最大重试次数

stateless: true # true无状态;false有状态。如果业务中包含事务,这里改为false- 开启本地重试时,消息处理过程中抛出异常,不会requeue到队列,而是在消费者本地重试

- 重试达到最大次数后,Spring会返回reject,消息会被丢弃

失败处理策略

在之前的测试中,本地测试达到最大重试次数后,消息会被丢弃。这在某些对于消息可靠性要求较高的业务场景下,显然不太合适了。 因此Spring允许我们自定义重试次数耗尽后的消息处理策略,这个策略是由MessageRecovery接口来定义的,它有3个不同实现:

RejectAndDontRequeueRecoverer:重试耗尽后,直接reject,丢弃消息。默认就是这种方式ImmediateRequeueMessageRecoverer:重试耗尽后,返回nack,消息重新入队RepublishMessageRecoverer:重试耗尽后,将失败消息投递到指定的交换机

比较优雅的一种处理方案是RepublishMessageRecoverer,失败后将消息投递到一个指定的,专门存放异常消息的队列,后续由人工集中处理。

@Configuration

@ConditionalOnProperty(name = "spring.rabbitmq.listener.simple.retry.enabled", havingValue = "true")

public class ErrorMessageConfig {

@Bean

public DirectExchange errorMessageExchange(){

return new DirectExchange("error.direct");

}

@Bean

public Queue errorQueue(){

return new Queue("error.queue", true);

}

@Bean

public Binding errorBinding(Queue errorQueue, DirectExchange errorMessageExchange){

return BindingBuilder.bind(errorQueue).to(errorMessageExchange).with("error");

}

@Bean

public MessageRecoverer republishMessageRecoverer(RabbitTemplate rabbitTemplate){

return new RepublishMessageRecoverer(rabbitTemplate, "error.direct", "error");

}

}业务幂等性

幂等是一个数学概念,用函数表达式来描述是这样的:f(x) = f(f(x)),例如求绝对值函数。 在程序开发中,则是指同一个业务,执行一次或多次对业务状态的影响是一致的。例如:

- 根据id删除数据

- 查询数据

- 新增数据

但数据的更新往往不是幂等的,如果重复执行可能造成不一样的后果。比如:

- 取消订单,恢复库存的业务。如果多次恢复就会出现库存重复增加的情况

- 退款业务。重复退款对商家而言会有经济损失。

所以,我们要尽可能避免业务被重复执行。 然而在实际业务场景中,由于意外经常会出现业务被重复执行的情况,例如:

- 页面卡顿时频繁刷新导致表单重复提交

- 服务间调用的重试

- MQ消息的重复投递

我们在用户支付成功后会发送MQ消息到交易服务,修改订单状态为已支付,就可能出现消息重复投递的情况。如果消费者不做判断,很有可能导致消息被消费多次,出现业务故障。 举例:

- 假如用户刚刚支付完成,并且投递消息到交易服务,交易服务更改订单为已支付状态。

- 由于某种原因,例如网络故障导致生产者没有得到确认,隔了一段时间后重新投递给交易服务。

- 但是,在新投递的消息被消费之前,用户选择了退款,将订单状态改为了已退款状态。

- 退款完成后,新投递的消息才被消费,那么订单状态会被再次改为已支付。业务异常。

因此,我们必须想办法保证消息处理的幂等性。这里给出两种方案:

- 唯一消息ID

- 业务状态判断

唯一消息ID

这个思路非常简单:

- 每一条消息都生成一个唯一的id,与消息一起投递给消费者。

- 消费者接收到消息后处理自己的业务,业务处理成功后将消息ID保存到数据库

- 如果下次又收到相同消息,去数据库查询判断是否存在,存在则为重复消息放弃处理。

我们该如何给消息添加唯一ID呢? 其实很简单,SpringAMQP的MessageConverter自带了MessageID的功能,我们只要开启这个功能即可。 以Jackson的消息转换器为例:

@Bean

public MessageConverter messageConverter(){

// 1.定义消息转换器

Jackson2JsonMessageConverter jjmc = new Jackson2JsonMessageConverter();

// 2.配置自动创建消息id,用于识别不同消息,也可以在业务中基于ID判断是否是重复消息

jjmc.setCreateMessageIds(true);

return jjmc;

}业务判断

业务判断就是基于业务本身的逻辑或状态来判断是否是重复的请求或消息,不同的业务场景判断的思路也不一样。

例如我们当前案例中,处理消息的业务逻辑是把订单状态从未支付修改为已支付。因此我们就可以在执行业务时判断订单状态是否是未支付,如果不是则证明订单已经被处理过,无需重复处理。

相比较而言,消息ID的方案需要改造原有的数据库,所以我更推荐使用业务判断的方案。

以支付修改订单的业务为例,我们需要修改OrderServiceImpl中的markOrderPaySuccess方法:

@Override

public void markOrderPaySuccess(Long orderId) {

// UPDATE `order` SET status = ? , pay_time = ? WHERE id = ? AND status = 1

lambdaUpdate()

.set(Order::getStatus, 2)

.set(Order::getPayTime, LocalDateTime.now())

.eq(Order::getId, orderId)

.eq(Order::getStatus, 1) // 未支付才处理

.update();

}UPDATE `order` SET status = ? , pay_time = ? WHERE id = ? AND status = 1兜底方案

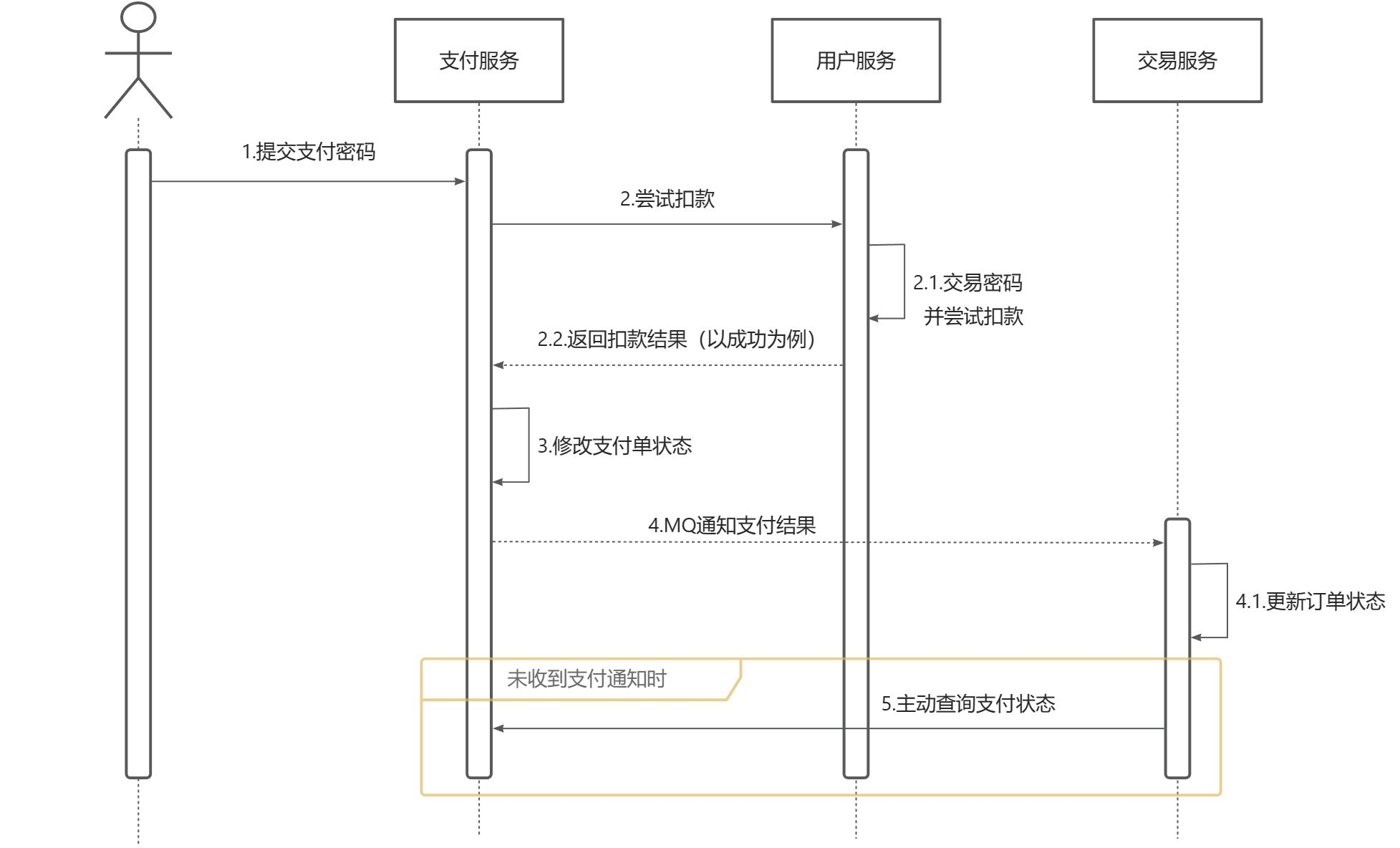

既然MQ通知不一定发送到交易服务,那么交易服务就必须自己主动去查询支付状态。这样即便支付服务的MQ通知失败,我们依然能通过主动查询来保证订单状态的一致。

利用定时任务定期查询,例如每隔20秒就查询一次,并判断支付状态。如果发现订单已经支付,则立刻更新订单状态为已支付即可。

延迟消息

- 延迟消息:生产者发送消息时指定一个时间,消费者不会立刻收到消息,而是在指定时间之后才收到消息。

- 延迟任务:设置在一定时间之后才执行的任务

在RabbitMQ中实现延迟消息也有两种方案:

- 死信交换机+TTL

- 延迟消息插件

死信交换机

当一个队列中的消息满足下列情况之一时,可以成为死信(dead letter):

- 消费者使用

basic.reject或basic.nack声明消费失败,并且消息的requeue参数设置为false - 消息是一个过期消息,超时无人消费

- 要投递的队列消息满了,无法投递

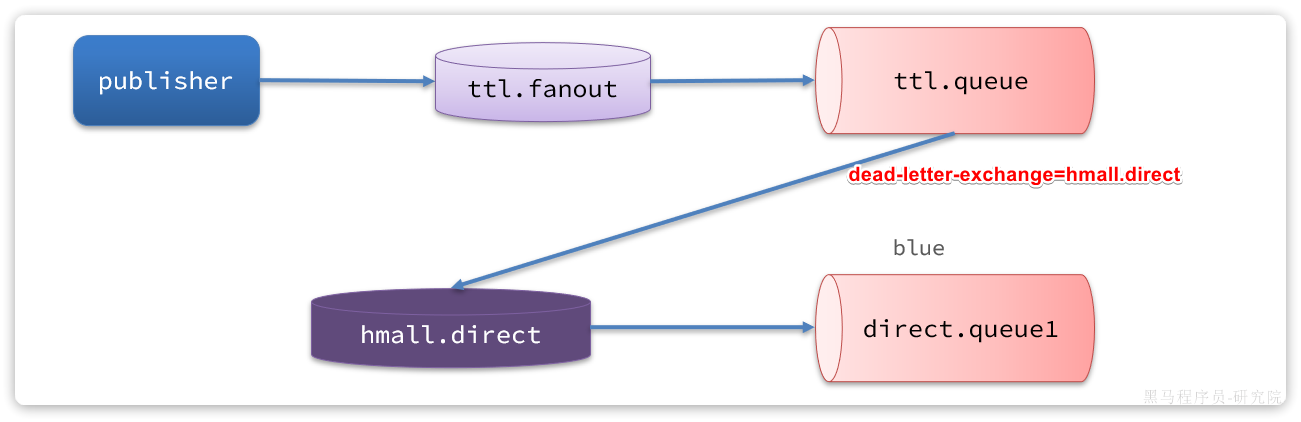

如果一个队列中的消息已经成为死信,并且这个队列通过dead-letter-exchange属性指定了一个交换机,那么队列中的死信就会投递到这个交换机中,而这个交换机就称为死信交换机(Dead Letter Exchange)。而此时加入有队列与死信交换机绑定,则最终死信就会被投递到这个队列中。

死信交换机有什么作用呢?

- 收集那些因处理失败而被拒绝的消息

- 收集那些因队列满了而被拒绝的消息

- 收集因TTL(有效期)到期的消息

延迟消息

前面两种作用场景可以看做是把死信交换机当做一种消息处理的最终兜底方案,与消费者重试时讲的RepublishMessageRecoverer作用类似。

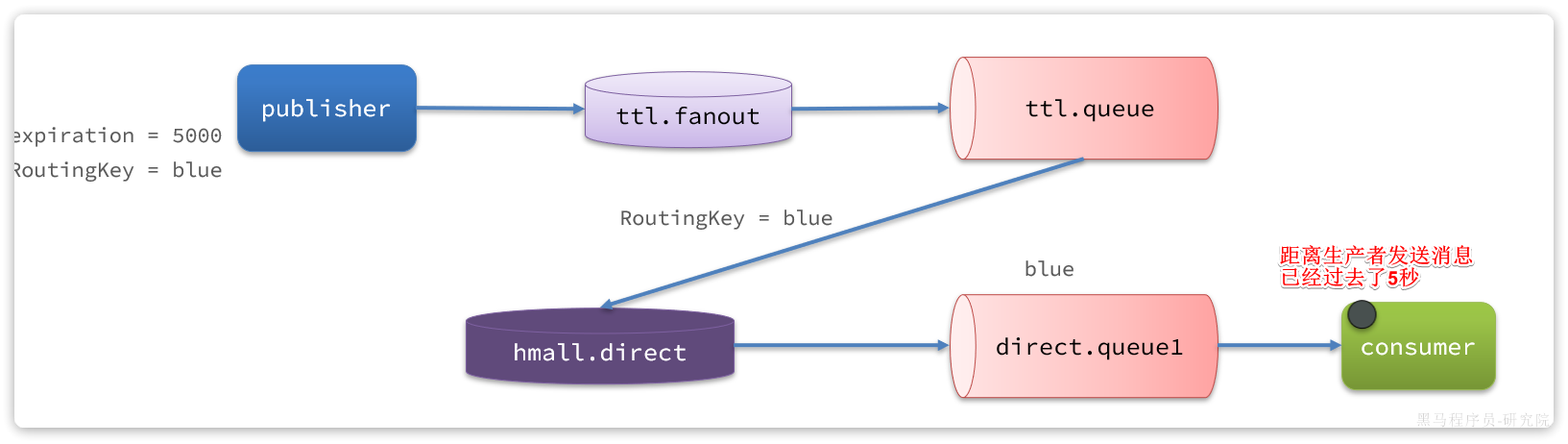

而最后一种场景,大家设想一下这样的场景: 如图,有一组绑定的交换机(ttl.fanout)和队列(ttl.queue)。但是ttl.queue没有消费者监听,而是设定了死信交换机hmall.direct,而队列direct.queue1则与死信交换机绑定,RoutingKey是blue:

假如我们现在发送一条消息到ttl.fanout,RoutingKey为blue,并设置消息的有效期为5000毫秒:

DelayExchange插件

https://github.com/rabbitmq/rabbitmq-delayed-message-exchange

https://blog.rabbitmq.com/posts/2015/04/scheduling-messages-with-rabbitmq

安装

因为我们是基于Docker安装,所以需要先查看RabbitMQ的插件目录对应的数据卷。

docker volume inspect mq-plugins结果如下:

[

{

"CreatedAt": "2024-06-19T09:22:59+08:00",

"Driver": "local",

"Labels": null,

"Mountpoint": "/var/lib/docker/volumes/mq-plugins/_data",

"Name": "mq-plugins",

"Options": null,

"Scope": "local"

}

]插件目录被挂载到了/var/lib/docker/volumes/mq-plugins/_data这个目录,我们上传插件到该目录下。

接下来执行命令,安装插件:

docker exec -it mq rabbitmq-plugins enable rabbitmq_delayed_message_exchange声明延迟交换机

基于注解方式:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "delay.queue", durable = "true"),

exchange = @Exchange(name = "delay.direct", delayed = "true"),

key = "delay"

))

public void listenDelayMessage(String msg){

log.info("接收到delay.queue的延迟消息:{}", msg);

}基于@Bean的方式:

package com.itheima.consumer.config;

import lombok.extern.slf4j.Slf4j;

import org.springframework.amqp.core.*;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Slf4j

@Configuration

public class DelayExchangeConfig {

@Bean

public DirectExchange delayExchange(){

return ExchangeBuilder

.directExchange("delay.direct") // 指定交换机类型和名称

.delayed() // 设置delay的属性为true

.durable(true) // 持久化

.build();

}

@Bean

public Queue delayedQueue(){

return new Queue("delay.queue");

}

@Bean

public Binding delayQueueBinding(){

return BindingBuilder.bind(delayedQueue()).to(delayExchange()).with("delay");

}

}4.2.4.发送延迟消息

发送消息时,必须通过x-delay属性设定延迟

@Test

void testPublisherDelayMessage() {

// 1.创建消息

String message = "hello, delayed message";

// 2.发送消息,利用消息后置处理器添加消息头

rabbitTemplate.convertAndSend("delay.direct", "delay", message, new MessagePostProcessor() {

@Override

public Message postProcessMessage(Message message) throws AmqpException {

// 添加延迟消息属性

message.getMessageProperties().setDelay(5000);

return message;

}

});

}